A Revolução da Inteligencia Artificial

Re: A Revolução da Inteligencia Artificial

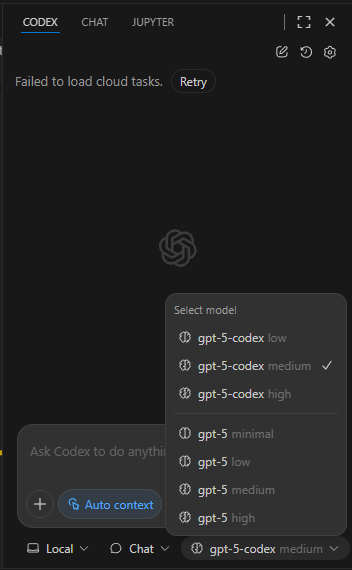

Entretanto, no serviço Codex, a OpenAI lançou/disponibilzou um novo modelo especializado em código: GPT-5-codex. Anteriormente estava disponível o GPT-5 (high).

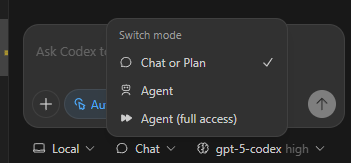

O serviço Codex está disponível no Plus, Teams/Business e Pro. Um aspecto interessante do Codex (que pode ser utilizado para chat "normal") é que é possível determinar/forçar o nível de esforço, o que não é possível na app/web:

O serviço Codex está disponível no Plus, Teams/Business e Pro. Um aspecto interessante do Codex (que pode ser utilizado para chat "normal") é que é possível determinar/forçar o nível de esforço, o que não é possível na app/web:

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Executives at xAI Clashed With Musk Advisers Before Departing

Some who left say they were concerned about the artificial intelligence company’s financial projections

Several executives at xAI left after clashing with two of Elon Musk’s closest advisers over concern about the startup’s management and financial health, according to people familiar with the matter.

Those advisers, Jared Birchall and John Hering, oversee the day-to-day operations of xAI while Musk, as chief executive officer, makes final decisions. Some of xAI’s executives voiced objections internally over how Birchall and Hering were trying to run the company on Musk’s behalf and felt there was no formal chain of command, the people said.

Some xAI executives said they left because they were concerned that some of the company’s financial projections were unrealistic, the people said. They also raised questions internally about the role Musk’s family office, Excession, played in managing some of xAI’s cash and accounting.

“The suggestion that the financials are in any way improper is false and defamatory,” Alex Spiro, a lawyer representing Musk, said in an email. He said the financials are audited by PricewaterhouseCoopers.

A person close to xAI said that it has full confidence in its projections.

A number of top executives have left xAI in recent months, including Linda Yaccarino, who was chief executive of X; Mike Liberatore; who was xAI’s chief financial officer; Igor Babuschkin, a former Google research scientist who was one of Musk’s first recruits to co-found xAI; and xAI’s general counsel, Robert Keele.

The executive conflicts inside xAI showcase how Musk’s unorthodox approach to running companies is complicating his ambitions to build the world’s dominant AI company.

(...)

The AI company turned to another Musk venture, SpaceX, for $2 billion in funding, the Journal first reported in July. During the summer, xAI representatives told some investors that it was discussing an investment from Tesla of at least $2 billion, people familiar with those discussions said.

“The notion that there is any issue raising capital for xai is demonstrably false and defamatory—the demand to invest has far outweighed the supply,” Spiro said in the email.

Tesla shareholders are set to vote on a proposal in November that would enable the company’s board to invest an unspecified amount in xAI. Musk has said that if it were up to him, Tesla would have invested in xAI a long time ago.

WSJ

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

DeepMind and OpenAI achieve gold at ‘coding Olympics’ in AI milestone

Artificial intelligence labs attain top grade in prestigious programming contest

Google DeepMind and OpenAI’s artificial intelligence models performed at a “gold-medal level” in a competition known as the “coding Olympics”, marking a milestone in the technology’s development.

The AI models achieved the result against the best human competitors at the International Collegiate Programming Contest (ICPC) World Finals in early September.

The competition is considered the most prestigious programming contest in the world. Former participants include Google co-founder Sergey Brin and OpenAI’s chief scientist Jakub Pachocki.

The ChatGPT maker’s AI models would have placed first in the competition, the company said on Wednesday. Its latest GPT-5 model solved all 12 problems, 11 of which it got on the first try. OpenAI and DeepMind were not official competitors.

DeepMind, the London-based laboratory run by British Nobel laureate Sir Demis Hassabis, meanwhile, said its AI reasoning model, Gemini 2.5 Deep Think, would have ranked second overall in the competition. It also solved a problem that no human competitor could complete.

(...)

In the coding competition, teams of three are given one computer with which to solve 12 hard programming problems in five hours. Teams are ranked on speed, accuracy and the number of questions they answer. This year, competitors were able to solve 10 out of the 12 questions. From the 139 competing teams this year, only four teams won gold medals.

(...)

OpenAI used its latest GPT-5 model for all problems except the final and hardest one, which it solved using a combination of GPT-5 and an experimental reasoning model.

(...)

FT

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

A OpenAI e a Anthropic concordaram em submeter os seus novos modelos ao USAISI (United States Artificial Intelligence Safety Institute) para avaliação antes do lançamento público e a Google está em negociações para fazer o mesmo

O USAISI vai ter acesso aos modelos, pré-lançamento, para realizar avaliações de segurança, saídas prejudiciais e comportamentos inesperados. O acesso será mantido mesmo após o lançamento oficial para testes continuados.

Numa notícia relacionada, a Californa passa uma lei de senado para a segurança de IA, obrigando à implementação de um "kill switch" caso a LLM comece a comportar-se erraticamente e a comprometer a segurança pública.

Que acham? Excesso de regulação que irá atrasar a investigação e desenvolvimento da IA ou um "mal necessário" para evitar que uma futura IA consciente decida personificar a Skynet (do filme Exterminador Implacável) e planear a extinção da humanidade?

O USAISI vai ter acesso aos modelos, pré-lançamento, para realizar avaliações de segurança, saídas prejudiciais e comportamentos inesperados. O acesso será mantido mesmo após o lançamento oficial para testes continuados.

In CNBC.com

OpenAI and Anthropic, two of the most richly valued artificial intelligence startups, have agreed to let the U.S. AI Safety Institute test their new models before releasing them to the public, following increased concerns in the industry about safety and ethics in AI.

The institute, housed within the Department of Commerce at the National Institute of Standards and Technology (NIST), said in a press release that it will get “access to major new models from each company prior to and following their public release.”

(...)

Numa notícia relacionada, a Californa passa uma lei de senado para a segurança de IA, obrigando à implementação de um "kill switch" caso a LLM comece a comportar-se erraticamente e a comprometer a segurança pública.

In arsTECHNICA

A controversial bill aimed at enforcing safety standards for large artificial intelligence models has now passed the California State Assembly by a 45–11 vote

(...)

As we've previously explored in depth, SB-1047 asks AI model creators to implement a "kill switch" that can be activated if that model starts introducing "novel threats to public safety and security," especially if it's acting "with limited human oversight, intervention, or supervision." Some have criticized the bill for focusing on outlandish risks from an imagined future AI rather than real, present-day harms of AI use cases like deep fakes or misinformation.

(...)

Que acham? Excesso de regulação que irá atrasar a investigação e desenvolvimento da IA ou um "mal necessário" para evitar que uma futura IA consciente decida personificar a Skynet (do filme Exterminador Implacável) e planear a extinção da humanidade?

Re: A Revolução da Inteligencia Artificial

alfa_2 Escreveu:

Para quem esteve por aqui em 1999/2000, deve lembrar-se da sensação que se vivia antes de rebentar a bolha das dot-com: qualquer notícia positiva parecia suficiente para empurrar os mercados ainda mais para cima. Nas últimas semanas, sinto um “déjà-vu” bastante semelhante…

(...)

A pergunta que fica é: estamos diante de mais uma bolha tecnológica ou é apenas um período de recuperação sustentada? Seja qual for a resposta, uma coisa é certa: o ambiente atual exige cautela, diversificação e atenção redobrada às avaliações de risco.

(...)

Sim, concordo que é necessária uma observação constante à "bolha das empresas de IA", especialmente à NVIDIA dada a cada vez mais ameaçadora concorrência dos chips chineses e das constantes evoluções e baixas dos custos de treino e inferência de LLMs que inevitavelmente fará abrandar a procura por chips da NVIDIA.

A questão agora será saber se esta revolução de IA ainda acelera mais:

Face a este cenário, as Magnificent 7, continuam com algum espaço para valorização continuada (será que já há mesmo uma bolha?)

Na bolha das Dot.Com estavamos nos primórdios da revolução digital, com uma enorme resistência à mudança por parte da população mundial. O Hype era grande mas os avanços reais eram pequenos e os resultados das empresas começaram a desapontar os investidores.

A IA teve aceitação imediata e adoção exponencialmente maior do que a informatização que se verificou na revolução digital (a resistência à mudança é menor).

Estamos a desbravar terreno, a economia vai-se transformar de uma maneira que ninguém consegue bem prever. Eu tendo a concordar com a visão do Elon Musk citada pelo previsor

previsor Escreveu:

"Chegará um ponto em que nenhum emprego será necessário; você pode ter um emprego se quiser, por satisfação pessoal. A inteligência artificial é capaz de fazer tudo. Não sei se isso deixa as pessoas confortáveis ou inquietas. Se é positivo ou negativo. Um dos desafios do futuro será: como encontramos propósito na vida?", questionou Musk.

Este ponto no tempo, aparentemente utópico, é chamado de "Singularidade": O momento em que a Inteligência Artificial supera toda e qualquer inteligência humana.

O timeline para isso acontecer? O Elon Musk sugere 2029/2030 como data possível (mas as previsões de datas do Musk são para rir, eu ainda estou à espera que o meu Tesla se conduza sozinho (legal e eficientemente)

As datas mais tardias apontadas por outros especialistas apontam para um range entre 2040 a 2050 para isso acontecer.

Eu por acaso, novamente concordo com o Musk, até 2030 poderemos chegar lá.

Notem que o Chat GPT foi lançado em 30 de novembro de 2022. Ainda não passaram 3 anos

Se já estamos neste ponto em 3 anos, a causar ondas de choque nos mercados de trabalho mundiais, onde estaremos daqui a 5?

Uma das peculiares características da IA é que é capaz de se ajudar a evoluir a ela própria, em tempo record, alcançando progressão e avanços exponenciais.

Re: A Revolução da Inteligencia Artificial

Para quem esteve por aqui em 1999/2000, deve lembrar-se da sensação que se vivia antes de rebentar a bolha das dot-com: qualquer notícia positiva parecia suficiente para empurrar os mercados ainda mais para cima. Nas últimas semanas, sinto um “déjà-vu” bastante semelhante…

O Nasdaq e o S&P 500 têm fixado novos máximos, mesmo com notícias que, em teoria, não justificariam grandes subidas. Ao mesmo tempo, o chairman da OpenAI não hesita em alertar: “Penso que estamos numa bolha e muitas pessoas vão perder muito dinheiro.”

Se olharmos para a economia global, vemos sinais mistos: a economia chinesa dá sinais de perda de força, o que tem dividido o mercado asiático, enquanto a Europa parece relativamente estável. Ainda assim, o sentimento de euforia nos EUA é palpável, lembrando claramente os dias que antecederam a bolha de 2000.

A pergunta que fica é: estamos diante de mais uma bolha tecnológica ou é apenas um período de recuperação sustentada? Seja qual for a resposta, uma coisa é certa: o ambiente atual exige cautela, diversificação e atenção redobrada às avaliações de risco.

"Nasdaq e S&P 500 fixam novos máximos"

https://www.jornaldenegocios.pt/mercado ... ra-o-verde

"Penso que estamos numa bolha e muitas pessoas vão perder muito dinheiro", diz chairman da OpenAI

https://www.jornaldenegocios.pt/empresa ... -da-openai

O Nasdaq e o S&P 500 têm fixado novos máximos, mesmo com notícias que, em teoria, não justificariam grandes subidas. Ao mesmo tempo, o chairman da OpenAI não hesita em alertar: “Penso que estamos numa bolha e muitas pessoas vão perder muito dinheiro.”

Se olharmos para a economia global, vemos sinais mistos: a economia chinesa dá sinais de perda de força, o que tem dividido o mercado asiático, enquanto a Europa parece relativamente estável. Ainda assim, o sentimento de euforia nos EUA é palpável, lembrando claramente os dias que antecederam a bolha de 2000.

A pergunta que fica é: estamos diante de mais uma bolha tecnológica ou é apenas um período de recuperação sustentada? Seja qual for a resposta, uma coisa é certa: o ambiente atual exige cautela, diversificação e atenção redobrada às avaliações de risco.

"Nasdaq e S&P 500 fixam novos máximos"

https://www.jornaldenegocios.pt/mercado ... ra-o-verde

"Penso que estamos numa bolha e muitas pessoas vão perder muito dinheiro", diz chairman da OpenAI

https://www.jornaldenegocios.pt/empresa ... -da-openai

Carteira: BABA; GOOGL; GPRO; XPEV; UBER

- Mensagens: 72

- Registado: 21/10/2014 18:38

Re: A Revolução da Inteligencia Artificial

Elon Musk prevê que inteligência artificial tornará todos os empregos obsoletos

Bilionário admitiu tentação em delegar parte de suas atribuições às máquinas

"Chegará um ponto em que nenhum emprego será necessário; você pode ter um emprego se quiser, por satisfação pessoal. A inteligência artificial é capaz de fazer tudo. Não sei se isso deixa as pessoas confortáveis ou inquietas. Se é positivo ou negativo. Um dos desafios do futuro será: como encontramos propósito na vida?", questionou Musk.

O magnata da tecnologia prosseguiu, dizendo que vislumbra uma "era de abundância". "Não teremos uma renda básica; teremos uma renda universal elevada".

Musk admitiu sua própria tentação em delegar parte de suas atribuições à IA.

"Frequentemente, me encontro em posição de descrença. Muitas vezes, quando estou na luta às 3 da manhã, penso: 'Por que estou fazendo isso, posso simplesmente esperar que a IA assuma isso'."

https://www.cnnbrasil.com.br/tecnologia ... hatgpt.com

Re: A Revolução da Inteligencia Artificial

NirSup Escreveu:Rolling_Trader Escreveu:A Albânia nomeou, pela primeira vez na história da humanidade, uma ministra de IA

1.º Nomear um «Ministro Virtual" para gerir compras públicas na Albânia não garante por si só o fim da corrupção.

Quem controla o algoritmo?

2.º Há exemplos semelhantes noutros países sendo o mais conhecido o sistema vigente na Coreia do Sul: KONEPS (Korea ON-line E-Procurement System), que já foi citado pelo Banco Mundial.

3. Se outros países não acompanham a Coreia do Sul nesta matéria é porque há muitos interesses instalados à volta da contratação pública, seja na Administração Central ou Local.

By Nirvana

Não tem que haver necessariamente um controlo do algoritmo.

Um algoritmo agentificado pode fazer uma deliberação, lançar outros agentes para validar essa deliberação e tomar a decisão final por votação de maioria.

O que tem de ser controlado e validado por organismos independentes (preferencialmente vários) é se o algoritmo está isento de vieses que possam tomar decisões que perpetuem a corrupção.

A ideia de uma IA decisora, impermeável a subornos e totalmente autónoma é meio caminho andado para eliminar a corrupção (bem como para eliminar a raça humana... era o argumento do filme "Exterminador Implacável"

Re: A Revolução da Inteligencia Artificial

Rolling_Trader Escreveu:A Albânia nomeou, pela primeira vez na história da humanidade, uma ministra de IA

1.º Nomear um «Ministro Virtual" para gerir compras públicas na Albânia não garante por si só o fim da corrupção.

Quem controla o algoritmo?

2.º Há exemplos semelhantes noutros países sendo o mais conhecido o sistema vigente na Coreia do Sul: KONEPS (Korea ON-line E-Procurement System), que já foi citado pelo Banco Mundial.

3. Se outros países não acompanham a Coreia do Sul nesta matéria é porque há muitos interesses instalados à volta da contratação pública, seja na Administração Central ou Local.

By Nirvana

It’s easy to make money in the stock market. What’s hard is choosing the winning horse. And only he wins the prize

Re: A Revolução da Inteligencia Artificial

Bem, esta profissão era uma que eu não esperava ver tão cedo substituída por IA.

A Albânia nomeou, pela primeira vez na história da humanidade, uma ministra de IA

A "ministra virtual" ficou responsável pelas compras públicas e tem como objetivo a eliminação da corrupção que assola o país nestas licitações públicas.

Assim derrepente consigo-me lembrar de dois ou três ministros(as) que podiam também ser substituídos por IA em Portugal

A Albânia nomeou, pela primeira vez na história da humanidade, uma ministra de IA

A "ministra virtual" ficou responsável pelas compras públicas e tem como objetivo a eliminação da corrupção que assola o país nestas licitações públicas.

In The Guardian

A digital assistant that helps people navigate government services online has become the first “virtually created” AI cabinet minister and put in charge of public procurement in an attempt to cut down on corruption, the Albanian prime minister has said.

(...)

Responsibility for deciding the winners of public tenders would be removed from government ministries in a “step-by-step” process and handled by artificial intelligence to ensure “all public spending in the tender process is 100% clear”, he said.

Diella would examine every tender in which the government contracts private companies and objectively assess the merits of each, said Rama, who was re-elected in May and has previously said he sees AI as a potentially effective anti-corruption tool that would eliminate bribes, threats and conflicts of interest.

(...)

Assim derrepente consigo-me lembrar de dois ou três ministros(as) que podiam também ser substituídos por IA em Portugal

Re: A Revolução da Inteligencia Artificial

Aparentemente a OpenAI "descobriu" porque as LLM alucinam e a conclusão parece-me bastante senso comum.

Numa versão muito resumida, o pós-treino das LLM basicamente condiciona-as a responder às nossas prompts como nós, humanos, responderiámos a um exame de escolha múltipla (daqueles que não têm penalização por respostas erradas).

Nesse caso, o mais lógico é responder a todas as perguntas do exame, mesmo quando não sabemos a resposta (advinhar não tira pontos).

A solução: Fazer o pós-treino penalizando respostas erradas e não penalizar a simples e honesta resposta de "não sei".

Voltando à analogia do exame de escolha múltipla, a maioria dos humanos não responderia às questões que não sabe se isso envolvesse uma penalização de pontos (a menos que se consiga eliminar grande parte das opções e ter uma probabilidade 50/50, o que, mesmo assim, é arriscado).

Posto assim é simples, certo?

Para uma explicação menos simples, i.e. com mais detalhes, podem ler o artigo publicado pela OpenAI sobre o tema.

Para "a explicação" científica, podem ler o research paper também publicado pela OpenAI.

Saliento para a o final da conclusão do paper, que cito:

Aqui fica dada a "dica" que os próximos modelos poderão reduzir, em grande escala, as alucinações com que ainda somos, por vezes, confrontados no uso das LLM, aliás isso está bem patente no final do artigo da Open AI

Numa versão muito resumida, o pós-treino das LLM basicamente condiciona-as a responder às nossas prompts como nós, humanos, responderiámos a um exame de escolha múltipla (daqueles que não têm penalização por respostas erradas).

Nesse caso, o mais lógico é responder a todas as perguntas do exame, mesmo quando não sabemos a resposta (advinhar não tira pontos).

A solução: Fazer o pós-treino penalizando respostas erradas e não penalizar a simples e honesta resposta de "não sei".

Voltando à analogia do exame de escolha múltipla, a maioria dos humanos não responderia às questões que não sabe se isso envolvesse uma penalização de pontos (a menos que se consiga eliminar grande parte das opções e ter uma probabilidade 50/50, o que, mesmo assim, é arriscado).

Posto assim é simples, certo?

Para uma explicação menos simples, i.e. com mais detalhes, podem ler o artigo publicado pela OpenAI sobre o tema.

Para "a explicação" científica, podem ler o research paper também publicado pela OpenAI.

Saliento para a o final da conclusão do paper, que cito:

In "Why Language Models Hallucinate" research paper

Simple modifications of mainstream evaluations can realign incentives, rewarding appropriate expressions of uncertainty rather than penalizing them. This can remove barriers to the suppression of hallucinations, and open the door to future work on nuanced language models, e.g., with richer pragmatic competence.

Aqui fica dada a "dica" que os próximos modelos poderão reduzir, em grande escala, as alucinações com que ainda somos, por vezes, confrontados no uso das LLM, aliás isso está bem patente no final do artigo da Open AI

In "Why Language Models Hallucinate" research publication

Our latest models have lower hallucination rates, and we continue to work hard to further decrease the rates of confident errors output by our language models.

Re: A Revolução da Inteligencia Artificial

BearManBull Escreveu:Rolling_Trader Escreveu:O que é mais caricato é que a única referência a MCP, no "seu" boneco, é o do tool calling feito pelas LLM atuais, o que eu referi que já deveria estar a ser feito e que você duvidou veementemente.

O MCP é usado como parte de uma framework para justamente para aumentar contexto, como é devidamente indicado.

O GPT também tem capacidade de ler diagramas. Melhor meter lá isso.

Você claramente julga-se mais inteligente que os outros para lhes chamar veladamente de "burros" (e já é a terceira vez que o faz).

Senão vejamos:

Mas neste caso a ignorância não está do meu lado pois é você que insiste em não responder à minha pergunta e quanto mais voltas dá à questão, mais ignorância demonstra.

Ainda estou à espera que me explique, detalhadamente por escrito, em que medida é que esta sua citação é verdadeira no contexto da imagem que forneceu:

BearManBull Escreveu:MCP é usado como parte de uma framework para justamente para aumentar contexto, como é devidamente indicado

Posso-lhe fornecer um desenho se isso o ajudar a perceber melhor a pergunta.

*Edição (adenda):

Relembro que as suas passadas citações, que geraram a "discórdia", foram também

BearManBull Escreveu:Na generalidade os LLMs conseguem fazer em termos micro o mesmo trabalho que fazem essas pessoas falta é a capacidade de acompanhamento e enquadramento para colaborar num processo empresarial e isso é por contexto diario que vao guardando e eliminando o que nao é necessário. Falta ali ou uma context window de terabytes ou um sistema orquestrador que guarda e recupera a informaçao por exemplo por MCP.

BearManBull Escreveu:Eu disse que se podia usar o MCP para implementar um arquitectura que emula um janela de contexto que seja suficientemente dinamica, fiavel e grande para o uso empresarial.

Há aqui uma clara dificuldade de você conseguir comunicar eficazmente o que quer dizer (e o problema não sou eu). O MarcoAntonio também tem dificuldade em entender o que você escreve, como ele próprio já o afirmou na sequência dos inúmeros posts sobre o "tamanho da janela de contexto".

Nessa discussão desisti de o entender, no entanto, sendo eu developer desde os meus 15 anos (tenho 50), confrontei-o quando você "atirou" o termo MCP para o ar como panaceia para "emular uma janela de contexto dinâmica, fiável e grande" (é que não gosto muito de pseudo tech gabarolas).

Estava à espera de um "não sei" ou de uma explicação cabal.

Mas não recebemos nem uma nem outra, você refugia-se em respostas evasivas (ou pior, respostas com imagens soltas), para além de insultos para desviar a conversa e inversões do ónus da prova.

Eu não tenho de provar nada, quem tem de o fazer é você dado que as afirmações foram suas.

Continuamos todos a aguardar ansiosamente que você responda assertivamente a como é que o MCP resolve estas 3 dimensões da context window que você referiu: dinamismo, fiabilidade e tamanho?

Re: A Revolução da Inteligencia Artificial

Rolling_Trader Escreveu:O que é mais caricato é que a única referência a MCP, no "seu" boneco, é o do tool calling feito pelas LLM atuais, o que eu referi que já deveria estar a ser feito e que você duvidou veementemente.

O GPT também tem capacidade de ler diagramas. Melhor meter lá isso.

“It is not the strongest of the species that survives, nor the most intelligent, but rather the one most adaptable to change.”

― Leon C. Megginson

― Leon C. Megginson

Re: A Revolução da Inteligencia Artificial

A Anthropic foi processada por violação de direitos de autor e chegou a um acordo legal para pagar pelo menos 1,5 mil milhões de dólares.

A notícia pode ser consultada em várias fontes noticiosas americanas como a Reuters ou o The Guardian, para nomear alguns.

O acordo pode ser consultado, na íntegra aqui

O que aconteceu foi que a Anthropic utilizou livros pirateados (provenientes de sites como o Library Genesis e o Pirate Library Mirror) para treinar os modelos Claude, achando que tal se enquadrava como "uso justo". E o juíz concordou em discordar

A Anthropic comprometeu-se a destruir os datasets dos livros pirateados, os ficheiros e quaisquer cópias dos mesmos, no prazo de 30 dias após a sentença final, e a fornecer prova dessa destruição, o que impede a reutilização futura dessas obras protegidas por direitos de autor no treino de novos modelos.

No entanto os modelos Claude atuais (e passados) vão-se manter treinados com base nesses dados. Não foi exigido à Anthropic que destruísse e reconstruísse os seus modelos, o que, segundo as fontes, "afundaria a Anthropic de um dia para o outro".

Este acordo é visto como um precedente jurídico significativo (especialmente no modelo legal dos EUA, diferente do português, em que a jurisprudência é um iceberg que tem de ser contornado em todos os futuros casos semelhantes).

Isto vai invevitavelmente levar a uma mudança da forma de aquisição de datasets para treino de IA, fugindo das "zonas cinzentas de legalidade", e incluíndo dados mais licenciados. Isso, provavelmente, resultará num aumento dos custos para as empresas de IA no treino dos seus modelos (que terão de investir mais na verificação da legalidade dos datasets) e obrigará os investidores a recalcular o ROI devido aos riscos de futuros processos jurídicos semelhantes.

Mais um "alfinente" para a alegada bolha de rentabilidade das empresas de IA?

A notícia pode ser consultada em várias fontes noticiosas americanas como a Reuters ou o The Guardian, para nomear alguns.

O acordo pode ser consultado, na íntegra aqui

O que aconteceu foi que a Anthropic utilizou livros pirateados (provenientes de sites como o Library Genesis e o Pirate Library Mirror) para treinar os modelos Claude, achando que tal se enquadrava como "uso justo". E o juíz concordou em discordar

A Anthropic comprometeu-se a destruir os datasets dos livros pirateados, os ficheiros e quaisquer cópias dos mesmos, no prazo de 30 dias após a sentença final, e a fornecer prova dessa destruição, o que impede a reutilização futura dessas obras protegidas por direitos de autor no treino de novos modelos.

No entanto os modelos Claude atuais (e passados) vão-se manter treinados com base nesses dados. Não foi exigido à Anthropic que destruísse e reconstruísse os seus modelos, o que, segundo as fontes, "afundaria a Anthropic de um dia para o outro".

Este acordo é visto como um precedente jurídico significativo (especialmente no modelo legal dos EUA, diferente do português, em que a jurisprudência é um iceberg que tem de ser contornado em todos os futuros casos semelhantes).

Isto vai invevitavelmente levar a uma mudança da forma de aquisição de datasets para treino de IA, fugindo das "zonas cinzentas de legalidade", e incluíndo dados mais licenciados. Isso, provavelmente, resultará num aumento dos custos para as empresas de IA no treino dos seus modelos (que terão de investir mais na verificação da legalidade dos datasets) e obrigará os investidores a recalcular o ROI devido aos riscos de futuros processos jurídicos semelhantes.

Mais um "alfinente" para a alegada bolha de rentabilidade das empresas de IA?

Re: A Revolução da Inteligencia Artificial

BearManBull Escreveu:Rolling_Trader Escreveu:

Gostava também que você desse uma explicação sucinta de porquê usar o MCP para atingir o objetivo que referiu. Porquê só um protocolo? E porquê o MCP em particular?

Então eu faço-lhe uma pergunta e você responde-me com um boneco dum powerpoint?

O seu insulto de há uns tempos, que cito:

BearManBull Escreveu:O que ficou claro aqui é que nao tens patavina ideia de como se usa o MCP nem consegues dar exemplos de uso

Não se aplica a si neste caso?

O que é mais caricato é que a única referência a MCP, no "seu" boneco, é o do tool calling feito pelas LLM atuais, o que eu referi que já deveria estar a ser feito e que você duvidou veementemente.

O que o "seu" boneco também deixou por responder foi o que você afirmou que poderia ser feito

BearManBull Escreveu:Eu disse que se podia usar o MCP para implementar um arquitectura que emula um janela de contexto que seja suficientemente dinamica, fiavel e grande para o uso empresarial.

O "seu" boneco não demonstra isso. É apenas um esboço, muito alto nível, de como implementar uma aplicação costumizada alavancada por LLMs. Todas as referências a MCP nesse gráfico dizem respeito àquilo para que o MCP serve, para integração com ferramentas externas.

Você sem um veio de transmissão não faz um carro a combustão, mas um veio de transmissão sozinho não faz um carro (a minha crítica ia nesse sentido).

Re: A Revolução da Inteligencia Artificial

Rolling_Trader Escreveu:

Gostava também que você desse uma explicação sucinta de porquê usar o MCP para atingir o objetivo que referiu. Porquê só um protocolo? E porquê o MCP em particular?

“It is not the strongest of the species that survives, nor the most intelligent, but rather the one most adaptable to change.”

― Leon C. Megginson

― Leon C. Megginson

Re: A Revolução da Inteligencia Artificial

Uma das notícias de hoje é precisamente sobre a francesa Mistral:

WSJ

Mistral AI Doubles Valuation to $14 Billion With ASML Investment

Fundraising led by Europe’s biggest tech company gives region’s top AI contender new firepower in its quest to build homegrown models

PARIS—Europe’s most prominent artificial-intelligence developer is tapping the continent’s biggest tech giant for cash to keep up in the global AI race.

Dutch chip-equipment giant ASML is pumping more than $1.5 billion into France’s Mistral AI for an 11% stake, leading a round valuing the Paris-based startup at nearly $14 billion—more than double its valuation last year. The ASML funds come as part of a roughly $2 billion round that Mistral says also includes Yuri Milner’s DST Global and French state-owned investment bank Bpifrance.

WSJ

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

MarcoAntonio Escreveu:O Claude Opus 4.1 está agora também disponível no acesso free, com 3 prompts por semana.

Entretanto, os utilizadores nos planos free têm acesso (ainda que limitado) praticamente aos melhores modelos disponíveis da OpenAI (GPT-5 Thinking, ainda que haja o Pro, inacessível para os free e para os plus), Google (Gemini 2.5 Pro, umas poucas prompts por dia), xAI (Grok 4 expert, ainda que haja o Heavy inacessível no free) e Anthropic (Claude Opus 4.1, só 3 prompts por semana, o mais limitado de todos).

Mas pelo menos os utilizadores podem experimentar e comparar aqueles que são (praticamente) os melhores modelos disponíveis comercialmente no momento, mesmo sem pagar.

Já agora, porque nem só do continente americano vêem bons modelos, uma referência honrosa para o francês Mistral, acessível, for free (com limitações) neste endereço: Le Chat

Aqui têm acesso a praticamente todas as funcionalidades incluídas nos mainstream AI Chats americanos, com o bónus de terem os vossos dados protegidos pelo RGPD visto que a Mistral tem sede na união europeia (França).

O modelo é o Mistral-medium-3.1, podem ler sobre o mesmo (e ver os benchmarks) no site oficial https://mistral.ai/news/mistral-medium-3

Re: A Revolução da Inteligencia Artificial

O Claude Opus 4.1 está agora também disponível no acesso free, com 3 prompts por semana.

Entretanto, os utilizadores nos planos free têm acesso (ainda que limitado) praticamente aos melhores modelos disponíveis da OpenAI (GPT-5 Thinking, ainda que haja o Pro, inacessível para os free e para os plus), Google (Gemini 2.5 Pro, umas poucas prompts por dia), xAI (Grok 4 expert, ainda que haja o Heavy inacessível no free) e Anthropic (Claude Opus 4.1, só 3 prompts por semana, o mais limitado de todos).

Mas pelo menos os utilizadores podem experimentar e comparar aqueles que são (praticamente) os melhores modelos disponíveis comercialmente no momento, mesmo sem pagar.

Entretanto, os utilizadores nos planos free têm acesso (ainda que limitado) praticamente aos melhores modelos disponíveis da OpenAI (GPT-5 Thinking, ainda que haja o Pro, inacessível para os free e para os plus), Google (Gemini 2.5 Pro, umas poucas prompts por dia), xAI (Grok 4 expert, ainda que haja o Heavy inacessível no free) e Anthropic (Claude Opus 4.1, só 3 prompts por semana, o mais limitado de todos).

Mas pelo menos os utilizadores podem experimentar e comparar aqueles que são (praticamente) os melhores modelos disponíveis comercialmente no momento, mesmo sem pagar.

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Qual é o problema

Nas pastas/projetos do ChatGPT (na versão web/desktop), quando existem muitas conversas, a lista aparece incompleta.

Consegues ver algumas, mas o scroll trava a meio → não dá para chegar ao fundo da lista.

A causa provável é um erro no CSS/JavaScript da interface, que aplica overflow: hidden no painel da lista, impedindo que o rato/trackpad façam scroll normal.

No telemóvel (app) este bug não acontece, porque o layout é diferente.

Quando vai ser resolvido

Até 6 de setembro de 2025, a OpenAI ainda não lançou correção oficial nem deu previsão.

O bug foi reportado desde março de 2025 em community.openai.com

e no Reddit, mas continua pendente.

Ou seja: não há data oficial — só se pode esperar que venha numa atualização futura da interface.

Como resolver (soluções temporárias)

Zoom out no navegador

Ctrl / ⌘ + – para reduzir → mostra mais conversas.

Usar outro navegador

Alguns (como Firefox ou Edge) lidam melhor com o scroll.

App móvel (Android/iOS)

A versão mobile permite scroll completo sem problemas.

Extensão “ChatGPT ScrollFix” (Chrome)

Força overflow-y: auto no painel e corrige o bug de forma automática.

Alterar manualmente via Developer Tools

Clica com botão direito → Inspecionar → seleciona o <div> da lista → altera overflow: hidden para overflow: auto.

Isso desbloqueia o scroll até ao fundo.

Re: A Revolução da Inteligencia Artificial

OpenAI pressed on safety after deaths of ChatGPT users

Attorneys-general of California and Delaware threaten to block tech group’s planned restructuring

The top state lawyers in California and Delaware wrote to OpenAI raising “serious concerns” after the deaths of some chatbot users and said safety must be improved before they sign off on its planned restructuring.

In their letter on Friday to OpenAI’s chair Bret Taylor, the attorneys-general said that recent reports of young people committing suicide or murder after prolonged interactions with artificial intelligence chatbots including the company’s ChatGPT had “shaken the American public’s confidence in the company”.

They added that “whatever safeguards were in place did not work”.

(...)

The pair’s intervention on Friday, and a meeting earlier this week with OpenAI’s legal team, followed “the heartbreaking death by suicide of one young Californian after he had prolonged interactions with an OpenAI chatbot, as well as a similarly disturbing murder-suicide in Connecticut”, they wrote.

Those incidents have brought “into acute focus . . . the real-world challenges, and importance, of implementing OpenAI’s mission”, the attorneys-general added.

Almost three years after the release of ChatGPT, some dangerous affects of the powerful technology are coming to light. OpenAI is being sued by the family of Adam Raine, who took his own life in April at the age of 16 after prolonged interactions with the chatbot.

The company announced this week that it would introduce parental controls for ChatGPT.

OpenAI has already ditched its original plans to convert the company into a for-profit, following discussions with the attorneys-general and under legal attack from Elon Musk and a number of other groups. Instead, it is seeking to convert only a subsidiary, allowing investors to hold equity while ensuring the non-profit board retains ultimate control.

Friday’s intervention suggests that even this more modest goal is under threat if OpenAI cannot demonstrate safety improvements.

“Safety is a non-negotiable priority, especially when it comes to children,” wrote the attorneys-general.

(...)

FT

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

@Rolling_Trader,

Em parte foi a razão porque fiz a distinção entre modelos genéricos e modelos especializados (a minha expectativa é que os problemas saiam pelo menos mitigados num modelo especializado). No entanto, não sei se concordo com a segunda parte (chaos of mind), pelo menos não o colocaria nestes termos nem diria exactamente que é "muito difícil". Nós temos uma capacidade notável para nos adaptarmos a diferentes contextos e áreas de actuação (o que não actuamos é necessariamente com o mesmo grau de expertise em todos; também temos limitações).

Em relação ao método de entrada e a utilização de voz, para já o impacto é (ainda, creio) largamente prático que outra coisa. Os modelos actuais continuam a ser tokenizers de texto ou equiparável em áudio. Normalemente, o que ocorre é que o sinal de voz (fala) é primeiro convertido em texto. Isto é, o modelo não digere directamente o sinal de fala, pelo menos em todo o domínio da informação nele contida, pelo que logo aí haverão perdas. A OpenAI diz que alguns dos seus modelos mais recentes já são nativamente multimodais, mas não creio que capture tudo o que descrevo de seguida. A conversão actual ou reconhecimento de voz/fala, incluindo via modelos neuronais, é suficientemente boa para capturar a componente prosódica, ou tom, sendo, por exemplo, capaz de distinguir uma pergunta de uma exclamação. Isto é basicamente inferível pelo percurso da frequência fundamental (f0 contour). Mas há perdas, como por exemplo na componente emocional. Nós, humanos, conseguimos literalmente distinguir se alguém disse algo a sorrir, a rir, desanimado, etc ou detalhes ainda mais subtis na prosódia que podem sugerir que não é apenas uma pergunta, por exemplo, que há pistas acústicas de ironia ou sarcasmo. Isto é, componente dita paralinguística.

Não estou a dizer que isto seja inalcançável num modelo neuronal e sei que é uma área de investigação activa em modelos exploratórios (ie, modelos directamente multimodais e/ou capazes de capturar inclusivamente informação paralinguística). Apenas que - tanto quanto sei - ainda não está completamente incorporado nos modelos actuais/comerciais que tendem a seguir uma pipeline mais simples ou mais limitada ( ASR/STT: fala -> texto com inferência prosódica ou paralínguistica básica/limitada, ou equivalente directamente no áudio; e não fala -> texto + pistas adicionais no sinal de fala, pelo menos na extensão com que nós humanos o fazemos naturalmente).

Claro que aqui a minha comparação é like-to-like: comunicação oral nos dois cenários. E o que estou a dizer, essencialmente, é que também aí ainda há um gap para preencher, ainda não é human-level também...

Em parte foi a razão porque fiz a distinção entre modelos genéricos e modelos especializados (a minha expectativa é que os problemas saiam pelo menos mitigados num modelo especializado). No entanto, não sei se concordo com a segunda parte (chaos of mind), pelo menos não o colocaria nestes termos nem diria exactamente que é "muito difícil". Nós temos uma capacidade notável para nos adaptarmos a diferentes contextos e áreas de actuação (o que não actuamos é necessariamente com o mesmo grau de expertise em todos; também temos limitações).

Em relação ao método de entrada e a utilização de voz, para já o impacto é (ainda, creio) largamente prático que outra coisa. Os modelos actuais continuam a ser tokenizers de texto ou equiparável em áudio. Normalemente, o que ocorre é que o sinal de voz (fala) é primeiro convertido em texto. Isto é, o modelo não digere directamente o sinal de fala, pelo menos em todo o domínio da informação nele contida, pelo que logo aí haverão perdas. A OpenAI diz que alguns dos seus modelos mais recentes já são nativamente multimodais, mas não creio que capture tudo o que descrevo de seguida. A conversão actual ou reconhecimento de voz/fala, incluindo via modelos neuronais, é suficientemente boa para capturar a componente prosódica, ou tom, sendo, por exemplo, capaz de distinguir uma pergunta de uma exclamação. Isto é basicamente inferível pelo percurso da frequência fundamental (f0 contour). Mas há perdas, como por exemplo na componente emocional. Nós, humanos, conseguimos literalmente distinguir se alguém disse algo a sorrir, a rir, desanimado, etc ou detalhes ainda mais subtis na prosódia que podem sugerir que não é apenas uma pergunta, por exemplo, que há pistas acústicas de ironia ou sarcasmo. Isto é, componente dita paralinguística.

Não estou a dizer que isto seja inalcançável num modelo neuronal e sei que é uma área de investigação activa em modelos exploratórios (ie, modelos directamente multimodais e/ou capazes de capturar inclusivamente informação paralinguística). Apenas que - tanto quanto sei - ainda não está completamente incorporado nos modelos actuais/comerciais que tendem a seguir uma pipeline mais simples ou mais limitada ( ASR/STT: fala -> texto com inferência prosódica ou paralínguistica básica/limitada, ou equivalente directamente no áudio; e não fala -> texto + pistas adicionais no sinal de fala, pelo menos na extensão com que nós humanos o fazemos naturalmente).

Claro que aqui a minha comparação é like-to-like: comunicação oral nos dois cenários. E o que estou a dizer, essencialmente, é que também aí ainda há um gap para preencher, ainda não é human-level também...

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

previsor Escreveu:Rolling_Trader Escreveu:Os Projects do ChatGPT são um exemplo excelente de criarmos e organizarmos contexto.

Acho que ainda tem muitas limitações, como não dar para arrastar conversas antigas e a organização em pastas não acelera o desempenho

Retiro o que disse sobre não ser possível arrastar conversas. Agora já dá. Há uns dias não dava.

Re: A Revolução da Inteligencia Artificial

Rolling_Trader Escreveu:Os Projects do ChatGPT são um exemplo excelente de criarmos e organizarmos contexto.

Acho que ainda tem muitas limitações, como não dar para arrastar conversas antigas e a organização em pastas não acelera o desempenho

Re: A Revolução da Inteligencia Artificial

MarcoAntonio Escreveu:(...)

Aquilo que tu referes, de se esperar (em larga medida) que o LLM “saiba o que estás a pensar”, é algo com que operamos o tempo todo na comunicação humano-humano. E funciona tanto melhor quanto melhor o interlocutor captura todo o contexto (de quem vem, onde a conversa está a ocorrer, quando está a ocorrer, na sequência de quê, etc.). Até a própria falta de contexto “local” pode ser uma pista forte!

(...)

Quem diz, quando diz, em que condições diz, tudo isso importa. Nós incorporamos imensa informação - frequentemente sem nos apercebermos disso - que não está no que é expresso literalmente. Se não temos um modelo do nosso interlocutor, rapidamente começamos a construir um. É nisto que me tenho estado a focar: a nossa poderosa ferramenta de construir um modelo do mundo e, como subset, construir modelos dos nossos interlocutores.

(...)

Alguém chega aqui ao fórum e escreve "hoje está um belo dia nos mercados". Com base em quem escreveu (é um utilizador habitual, familiar com o fórum? é um utilizador novo? onde escreve, dentro de um tópico específico? ou abriu um tópico só para escrever isto?), eu infiro uma série de coisas.

(...)

Como micro-experiência, coloquei isso mesmo num prompt no GPT-5 Thinking (Plus). O GPT-5 Thinking (Plus) sabe inclusivamente que eu estou familiarizado com os mercados e que é um dos meus vários focos de interesse. Mesmo assim, o que fez? Primeiro começou a pesquisar informação atual sobre mercados (no fórum, ao ler isto escrito num sábado por um utilizador familiar com os mercados, eu não perderia tempo a ir ver cotações - eu já sei que ele está no “gozo” ou a ser irónico.

(...)

Para rematar: o que discuto não é propriamente matéria nova e, tanto quanto sei, a integração/modelização de Theory of Mind nos modelos atuais é uma área ativa de desenvolvimento...

Concordamos no essencial, porém creio que há aqui uma ressalva importante a fazer com base no "quote" que fiz do teu último post Marco.

O problema é que, para qualquer Chat Bot, o método de entrada é mesmo, uma janela de chat de texto, onde escrevemos a qualquer hora do dia ou da noite, não só sobre bolsa mas também sobre tudo "e mais um par de botas", desde a pedido de sugestões para jantar, a aconselhamento para problemas pessoais, e a pedidos de ajuda para tarefas específicas do trabalho.

Seria muito difícil para um humano servir de amigo, confidente, colega, psicólogo, médico, tutor, etc, sendo constantemente "massacrado" com perguntas de diferentes temas feitas de maneira aleatória e desordenada.

Neste caso, a Theory of Mind seria mais um Chaos of Mind. O ser humano não iria conseguir lidar com este caos e a IA também não.

Depois temos o problema do meio de comunicação com... Mensagens de Texto.

Mesmo na comunicação entre dois seres humanos, via texto simples, a "impossibilidade" de imprimir um tom de voz diferente torna difícil a interpretação das mensagens pelo outro interlocutor.

É fácil soar agressivo numa mensagem de texto (ou email) quando não é essa a nossa intenção, tal como é fácil fazer engenharia social e termos um humano a enganar outros humanos via Whatsapp (ou similar).

A mais recente inovação de poder comunicar com alguns chatbots por voz pode ajudar a colmatar este problema, mas creio que, via texto, é impossível arranjar um algoritmo ou ideia que consiga extrair contexto de uma janela de chat aberta do nada, a qualquer hora do dia ou da noite.

O que tenho vindo a tentar comunicar nestes últimos posts (quando comecei pela engenharia de prompts) é que, quem nos pode ajudar neste momento, somos nós próprios... seja aprendendo engenharia de prompts seja a usar funcionalidades dos chats de IA que nos permitem organizar o contexto, como os Projects do ChatGPT

A propósito, o Chat GPT fez o "rollout" da funcionalidade "Projects" para o plano gratuito.

Os Projects do ChatGPT são um exemplo excelente de criarmos e organizarmos contexto. Por exemplo, posso criar um projeto para me servir de "médico de família", coloco lá todo o meu contexto médico relevante (historial clínico, medicação habitual, problemas de saúde na família, hábitos tabágicos ou outros, exames, consultas, idade, peso) e direciono todas as minhas perguntas médicas, sobre a minha saúde, a esse projeto em particular.

Dessa forma não tenho de estar recorrentemente a repetir informação de contexto cada vez que abro uma janela de chat nova e vou obter respostas mais relevantes sobre a minha saúde.

Agora cuidado, não façam perguntas sobre o exame médico da esposa no Project que criaram com a informação de contexto da vossa saúde pessoal.

Quem está ligado: